Anbieter zum Thema

Herausforderungen konventioneller Server- und Storage-Konfiguration unter Hadoop

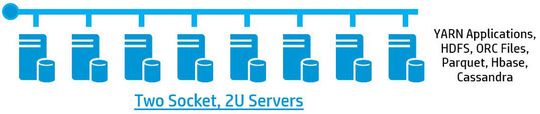

Bei dem Einsatz insbesondere im Hadoop-Umfeld sind Standard-Server häufig in einer shared-nothing Architektur zu einem Cluster verbunden. Je nach Anwendungsfall werden jedoch zum Teil unterschiedliche Server- und Workload-Profile gefordert. So entstehen meist für jeden Use-Case und Fachbereich dedizierte Infrastrukturen. Das führt dazu, dass komplett unterschiedliche Workloads wie Insellösungen nebeneinanderstehen (siehe: Abbildung 1).

Wenn man beispielsweise Daten im Analytics-Bereich nutzen will, die im NoSQL bearbeitet wurden, müssen sie zwischen den Systemen kopiert werden. Das erhöht die Komplexität und stellt eine Herausforderung für das System dar. Außerdem stößt die beliebig große Auslegung der Cluster mit günstiger Hardware schnell an ihre Grenzen. Anforderungen an CPU und Memory haben sich durch die schnelllebige Entwicklung des Hadoop Öko-Systems stark geändert. Zudem nimmt der Administrations- wie auch Wartungsaufwand der einzelnen Insellösungen kontinuierlich zu.

Eine moderne Referenzarchitektur

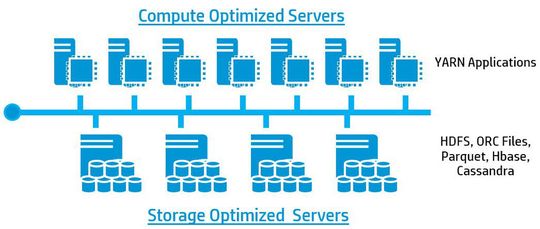

Ein moderner Ansatz für eine Referenzarchitektur auf Basis von Hadoop 2.x kommt von HP. Dabei werden die Server- und Storage-Schicht voneinander getrennt und individuell gemanagt. Sämtliche Daten werden in einem großen Storagepool (Datenlake) gespeichert und die Performance darüber so aufgebaut, dass sie NoSQL, Analytics und Hadoop abdeckt und darüber auf alle Daten zugegriffen werden kann. Dadurch reduziert sich die Komplexität extrem, zusätzlich werden weniger Rechenzentrumsstellfläche, weniger Strom und Kühlung benötigt.

Der Vorteil dieser Konfiguration liegt darin, dass sie asynchrones und somit ein bedarfsgerechtes Skalieren erlaubt. Das bedeutet, man muss im Vorfeld nicht detailliert wissen, wohin sich die Anwendung entwickeln wird und man kann die Daten unstrukturiert im Datenlake ablegen.

Sowohl Workloads als auch Speicher können einem optimierten Node zugeordnet werden. Je nach Bedarf des Anwenders kann der Datenlake von Anfang an bedarfsgerecht dimensioniert und später beliebig vergrößert werden. Dasselbe gilt auch für den CPU-Bereich, der sich bei höheren Analyseanforderungen dynamisch dimensionieren lässt. Ändern sich die Anforderungen, so kann jederzeit nachjustiert werden.

Höhere Verfügbarkeit und schnellere Verarbeitung

Der Vorteil der asynchronen Skalierung liegt darin, dass mehrere Workloads auf einer Infrastruktur laufen können. Ein Bereich übernimmt das Datenbetanken, der andere gleichzeitig die Analyse. Das erlaubt sogenanntes Workload Tiering, das heißt, es können verschiedene Workloads dediziert Cluster Ressourcen zugewiesen werden. Dabei kann ein Standard Hadoop System eingesetzt werden. Eine Virtualisierung ist nicht erforderlich.

Diese moderne Referenzarchitektur erhöht die Verfügbarkeit der Daten und die Geschwindigkeit der Verarbeitung. Sie erlaubt mehr Flexibilität und bietet Anwendern, die den Use-Case im Vorfeld nicht genau bestimmen können, mehr Spielraum für die Entwicklung.

Somit eignet sie sich sowohl für kleine und mittlere Unternehmen, als auch für den Enterprise-Bereich, um neue Geschäftsmodelle kosteneffizient und sicher zu entwickeln. Die integrierte Lösung vom Server über Storage und Netzwerk bis zur Software wird individuellen Anforderungen an Big-Data-Lösungen zukunftsorientiert gerecht. Sie ist wie ein Motor für einen SUV, der für vielseitige Zwecke einsetzbar ist.

* Andreas Bachmann ist Manager Presales HP Storage & Big Data, und Philipp Koik, Presales Consultant Big Data, HP Enterprise Group.

Artikelfiles und Artikellinks

(ID:43446460)

:quality(80)/p7i.vogel.de/wcms/2b/e5/2be553a4fae2042442acf71825155af4/0129701558v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/50/dd/50dd3b34f7b0225abc3ee94da6c93031/0129530493v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/1a/ba/1aba22332932c34e5a76094302dfaf82/0129450920v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8c/21/8c21b1401a42efba38ae38b98090007f/0129402963v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/fb/5f/fb5f1d119682e3623cd9fff5fa80b244/0129756328v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/02/83/0283373f8f8e82d18935527664deedc6/0129742716v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/99/92/9992edf50bde9f19ae3ddc6beeb4a621/0129612565v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d1/5e/d15e1fef97d76b047f8f8029360f35a3/0129605177v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/11/d7/11d7023749c001c6dbe5330173cb0a98/0129605202v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/cb/b4/cbb4b255cd3d4f6b54b51e58999dccc3/0129607867v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/91/4a/914a0c353fc9a5c09060cce2805438ab/0129671222v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9d/ea/9deaefad64391e095f64f83ea24fdf71/0129682598v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ff/3e/ff3e593fc00cc07dabb6cb0e9fe0a4a8/0129416033v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/be/ae/beaefe01a87a8cefddaa3de66838f68b/0129578464v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/f8/2f/f82f4f38e4c5dc9e6fff85e539341ff1/0129455026v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/e2/26/e226b8c617a42d5490e7a866389dff9b/0129662407v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/67/3d/673df458f785f25b05d17f06a62651d1/0129501448v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/f2/14/f214043747c0e09946ba7628365f3c69/0129468201v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4f/f3/4ff3f0f86eb10677bbdc6b5b7949f217/0129421148v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/bb/c3/bbc39c16eb8a1435fa7a974dbea2c2a0/0129384459v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/c5/79c5cb8545ed8769f643490ecee932a1/0129176937v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/26/2f/262f083e2c891a10c19df1524d341824/0129677887v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/5c/11/5c11f1045ad338000113a97d33f44a03/0129446649v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/b6/b8/b6b861346b607b7ecc0b60dc45c46012/0129449658v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/b0/12/b012932ba5620e0474b49487335dc84d/0129309312v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/da/ee/daeee14a1cdb5c1372c446d20f8a7f25/0129370055v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/f9/b5/f9b5d109b375976c27c4ee344442e86a/0129767425v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/25/21/252182b4b622ffd3310bbd049a759f15/0129760749v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/fe/77/fe77ca9bb0b9a621f386e12597ba6796/0129687398v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/dc/a5/dca5a04431fe99aefaaa9a529fda76b1/0129685092v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f3/da/f3dacd38e5834ae3f3c9d0a4bc9664d3/0113348475.jpeg)

:quality(80)/p7i.vogel.de/wcms/90/f5/90f56ec6cb3ddbdabca2162fd5477836/0113078524.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/09/0f097990002b7600075e43c92af4a3fd/0110524571.jpeg)

:quality(80)/p7i.vogel.de/wcms/66/ae/66ae9e32738784b57e2ad8c1a4b0986f/0109756744.jpeg)

:quality(80)/p7i.vogel.de/wcms/ca/ed/caed4bcd5928209cfdc9ae69f0d31dfd/0129561608v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ee/3f/ee3f063b82737f0369c09ba7854587b5/0127234708v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f1/f0/f1f007a4518fa65d3cb0ea5ca465142a/0121300054v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/a8/28/a828f76369267628d833a12c26dd6579/0121131534v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/8a/c28a3e2b1e5a668e85a60ab1513f0505/0114961639.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/5f/74/5f7479b1443af/panduit-logo2015-bp-below-aligned-tm.jpg)

:fill(fff,0)/p7i.vogel.de/companies/66/c3/66c33d1f71ef2/daxten-logo-600-x-600.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/67/92/67921e1a932db/logo-pqplus---rgb.jpeg)

:quality(80)/p7i.vogel.de/wcms/26/2f/262f083e2c891a10c19df1524d341824/0129677887v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/9f/18/9f180647d8eee5cfcc3ee910aba0c522/0128802998v1.jpeg)