Anbieter zum Thema

Die Schwächen von Hadoop

In der Theorie scheint Hadoop unschlagbar. Die Herausforderungen zeigen sich aber spätestens dann, wenn Hadoop in eine vorhandene IT-Landschaft eingefügt werden soll. Als Stolpersteine haben sich in vielen Fällen die Open-Source-Datenbankschnittstellen erwiesen, die ODBC nur unvollständig unterstützen.

Der Schwachpunkt: Ohne die ODBC-Kernfunktionen wird es sehr schwierig, die vorhandenen Business-Intelligence (BI)-Applikationen auf Hadoop abzustimmen. Oft gelingt dies nur über sehr waghalsige und komplexe Programmierumwege.

Hadoop verträgt sich zum gegenwärtigen Zeitpunkt noch nicht sonderlich mit dem in den meisten Unternehmen vorhandenen Datenanalyse- und Visualisierungs-Tools. Bevor diese Lücke nicht geschlossen ist, können Unternehmen nicht alle Vorteile von Hadoop nutzen.

ODBC – so wertvoll wie nie

Unternehmen benötigen jedoch schnelle ODBC-kompatible Datenbankschnittstellen, die sie zusammen mit ihren BI-Applikationen einsetzen können. Da nahezu alle bedeutenden BI-Plattformen ODBC als Interface nutzen, wird ODBC zum Schlüsselfaktor für den Zugriff auf Hadoop-Datenbestände. Es gibt bereits eine Reihe von Ansätzen, um die „reduzierten Daten“ in traditionelle Data-Warehouses zu importieren und sie so für das vorhandene Ecosystem von Analyse-Tools zugänglich zu machen.

Eine Lösung dafür bietet beispielsweise die Datenbankschnittstelle „Data Direct Connect XE ODBC für Hadoop Hive“ von Progress Software (siehe: Kasten).

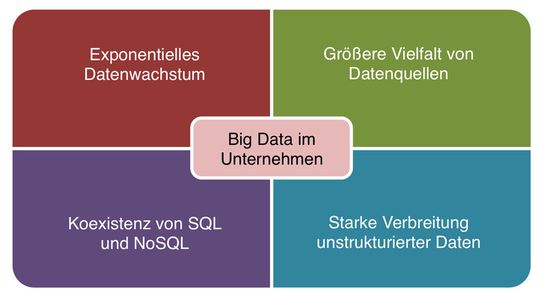

Größe, Geschwindigkeit und Datenvielfalt

Big Data bezeichnet zunächst einmal die Verarbeitung sehr großer Datenmengen. Vielfach spielt auch die Geschwindigkeit, mit der die Verarbeitung und Bereitstellung der Ergebnisse erfolgen soll, eine Rolle. Während beispielsweise Fachbereiche früher oftmals einen Tag auf Ergebnisse warten mussten, stehen mit aktuellen Big-Data-Verfahren die Resultate sehr komplexer Analysen nach wenigen Stunden zur Verfügung. So nutzen etwa Energieunternehmen verteilte Sensoren, sehr schnelle Kommunikationsnetze und Data-Mining-Techniken, um Bohroperationen optimal aufeinander abzustimmen.

Hier kann es aus Geschwindigkeitsgründen genügen, dass die Ergebnisse nach einigen Stunden vorliegen – und damit deutlich schneller als früher. Eine deutlich andere Anforderung an die Geschwindigkeit gibt es bei der Auswertung von Webstatistiken eines Online-Shops. Hier müssen die Resultate sofort vorliegen, um Besuchern und Käufern zusätzliche und für sie passende Angebote machen zu können.

Hadoop und andere Ansätze stehen heute erst am Anfang. Für Unternehmen kommt es darauf an, die mit Big-Data verbundenen Prozesse und Technologien zu meistern, ohne die vorhandenen Systeme zu vernachlässigen. Besonders effiziente Lösungen werden sich vor allem aus einer Kombination von vorhandenen und neuen Technologien wie ODBC, Java und Hadoop ergeben.

Der Autor:

Jesse Davis ist Director Research and Development bei Progress Data Direct.

(ID:36793150)

:quality(80)/p7i.vogel.de/wcms/2c/0b/2c0bf1554a667c1e6ebe72d8cf5de318/0129023435v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/7e/82/7e82b40a8af905b10f8280a3ab2d2af8/0129028395v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/0c/9b/0c9b3a59a2dfb472b62819fc3852b646/0129091477v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/bc/fd/bcfd9fc11608668b553c80b448ad228a/0128622890v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/97/43/97431d32619b1d50c9dcc4d30565294d/0129126406v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/01/e4/01e46d70bd163fc46157a9407ab5206b/0129100911v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/6d/69/6d69e6596d5440b5ba7fd85cef0a7115/0129100796v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/60/c4/60c446f716e0f29c55577286f99a6a29/0129282372v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/24/1a/241abe11ef2123689dbc2f662b36a27b/0129111319v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ea/f7/eaf76127817331fbcc2cb511b9d388d3/0129096918v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d3/ec/d3ec1c624624f601f99e6c7cc44c3518/0129204330v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/c5/79c5cb8545ed8769f643490ecee932a1/0129176937v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/7e/c27e5af026ae01b18c768fc104eb6d13/0129183722v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/74/27/74271263c70cfb918d80070c01ff4766/0129130135v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e6/4d/e64d5d57da98b5250140953efc5ef6a8/0129134612v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/30/24/3024f92f54e935b052925a14c678ec52/0129142844v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/6d/70/6d70da34e3cfbb2e34505cbd2a492e3d/0129051553v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/1d/6d/1d6d32845786e3f2f391e79b2fbcda22/0129021891v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/c5/55/c55510d60e45cf74f1d55d4ed3146115/0129028080v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/54/87/54871fcc908d2e3be0b2f0394bfbf6d1/0129115949v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/55/08/5508fbb080a2637959915e0fd5bdd512/0129044131v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/17/f7/17f7b94674a7e16c4b59f57b58d87782/0128989258v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/bb/61/bb612b10c0040497431fe3ddd4373ecb/0128894300v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/53/9c53a7ad3c500e614f94151ba7963dae/0128405199v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/44/60/44601c8907a240b5075a21f6983f18b2/0128307616v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/bc/7b/bc7b32c6de0c0a4a76694b630499bf56/0128129676v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/19/9a/199a2d2f04027101e40223440578aacc/0129287868v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f7/9a/f79a661bd04dee4897a0da5ee5baddbd/0126557542v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/0a/d5/0ad5a172a9a58ed0bcdd1666374a4f98/0129236129v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/1c/97/1c9700bc3e5a943e2ce4ae42b14bf321/0129175891v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f3/da/f3dacd38e5834ae3f3c9d0a4bc9664d3/0113348475.jpeg)

:quality(80)/p7i.vogel.de/wcms/90/f5/90f56ec6cb3ddbdabca2162fd5477836/0113078524.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/09/0f097990002b7600075e43c92af4a3fd/0110524571.jpeg)

:quality(80)/p7i.vogel.de/wcms/66/ae/66ae9e32738784b57e2ad8c1a4b0986f/0109756744.jpeg)

:quality(80)/p7i.vogel.de/wcms/38/8e/388e4dbb6ebe27e60b55283b8c21fda2/0129173166v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/ee/3f/ee3f063b82737f0369c09ba7854587b5/0127234708v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f1/f0/f1f007a4518fa65d3cb0ea5ca465142a/0121300054v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/a8/28/a828f76369267628d833a12c26dd6579/0121131534v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/8a/c28a3e2b1e5a668e85a60ab1513f0505/0114961639.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/68/f7/68f771f60cae6/kentix-logo-endorsed-colored-rgb.png)

:fill(fff,0)/p7i.vogel.de/companies/65/65/6565ddb7b8418/dcg-wort-bild-marke-dark-rgb.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/67/ac/67ac72eb8ec04/stackit-logo-rgb-regular-petrol-mz-big.png)

:quality(80)/p7i.vogel.de/wcms/9d/71/9d71f9684107449ee996dedf669c119b/0123467697v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/a4/68/a4680e128709c578e103b4db8055f524/0127349911v1.jpeg)