Anbieter zum Thema

Mögliche Sackgassen sind aus heutiger Sicht:

- Fehlende Kompatibilität der Lösungen zwischen Herstellern

- Die notwendige Infrastruktur erreicht nicht den notwendigen Reifegrad

- Die Technologien erweisen sich als zu komplex für eine Massennutzung

- Die Orchestrierungs-Ebene kann so nicht umgesetzt werden

- Die technologischen Risiken sind also signifikant, alles andere wäre auch verwunderlich. Einsparungen in der angesprochenen Dimension fallen eben nicht als Wunder vom Himmel.

Aber das ist gar nicht das dominierende Problem!

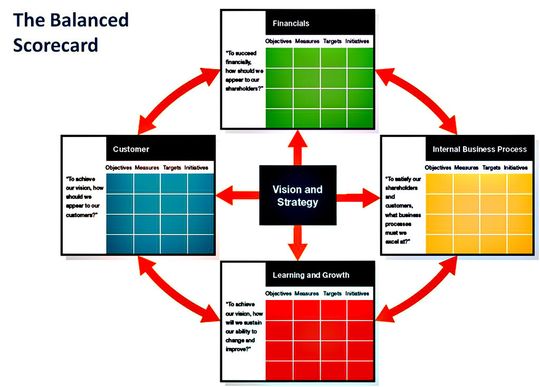

Wir hatten zum Beispiel die Diskussion um die bei Harvard entwickelte Balanced Scorecard in den 90er Jahren. Die hat sich im großen Stil nie durchgesetzt. Dabei ist sie im Kern unverzichtbar für jede Service-Organisation.

Man mag ihr vielleicht einen anderen Namen geben, aber inhaltlich wird man große Teile umsetzen müssen, auch wenn das Abstraktionsniveau auf den ersten Blick abschreckend ist.

Die Kernfragen sind:

- Sind unsere Rechenzentren wirklich organisatorisch so weit, dass sie ihre Leistungen in Form eines Service-Katalogs anbieten können?

- Ist es gewünscht, dass Kunden aus den Abteilungen sich selber ihre Ressourcen Applikationen auswählen und starten?

- Ist ein Rechenzentrum wirklich in der Lage, einen Preise für alle diese Services zu nennen und auch verbrauchsabhängig zu berechnen?

- Ist der Kunde gewillt, eine Trennung zwischen Preis und Ressource zu akzeptieren?

Die Service-Spezifikation ist die Basis

Die Service-Spezifikation ist das Fundament jeder erfolgreichen Service-Erbringung. Das Dilemma des Kunden darf dabei nicht unterschätzt werden. Dabei geht es gar nicht um die wenigen großen Anwendungen eines Unternehmens wie SAP oder Email. Es geht um die manchmal tausenden von kleinen Spezialanwendungen, die auch im Kern das eigentliche Problem sind. Kaum ein Unternehmen hat Probleme damit, Exchange effizient zu betreiben (oder sollte es Probleme damit haben, dann ist das schnell lösbar). Was passiert mit der Vielzahl der kleineren Applikationen? Beispiel aus der Vergangenheit: eine Abteilung hat Geld für ein Projekt und sagt dem RZ: „Kauf mal einen Server und Speicher für diese Applikation und bring sie zum Laufen“. In Zukunft müsste kein Server mehr gekauft werden, sondern ein Template müsste aufgesetzt werden, damit der Kunde seine Applikation eigenständig aktivieren, starten, optimieren und terminieren kann. Der Kunde bezahlt einen Preis für eine Leistung, die er nun nicht mehr bildlich greifen kann.

Damit ist eine Reihe von Fragen verbunden:

- Werden gerade bei den vielen Projekt-basierten Server-Installationen die Kunden bereit sein, auf „ihren“ Server, also speziell auf den Nachweis einer von ihrem Geld gekauften Ressource zu verzichten?

- Lohnt sich der Aufwand der Automatisierung und Template-Erzeugung wirklich für jede kleine Applikation?

- Wer berechnet eigentlich den Preis und wie erfolgt die Abrechnung?

Neben den technischen Hürden hat das Software Defined Data Center eine hohe technologische Hürde. Die ist nicht unlösbar, aber wie gesagt, dieses Problem der Schaffung und Umsetzung von Service-Katalogen ist nicht neu. Und bisher hat es kaum funktioniert. In diesem Sinne wird es Zeit, sich von der Technik-Diskussion zu lösen und eine Service-Diskussion zu starten.

Damit kommen wir auch zum Fazit und den Empfehlungen von ComConsult Research:

- Die Technologien, die sich um den Begriff Software Defined Data Center ranken, werden in Stufen relevant für den Markt werden. Im Moment gehen wir von einem Zeitrahmen von drei bis fünf Jahren aus.

- Gerade zu Beginn dieser Phase werden Projekte je nach Ziel aufwendiger und kostenintensiver sein als später mit einem höheren Reifegrad der Produkte.

- Ein Einstieg in die Technik ohne die Festlegung eines langfristigen Zieles wird aller Voraussicht nach scheitern. Das Software Defined Data Center unterstellt implizit eine komplette Service-Orientierung der IT-Infrastruktur. Mit der Service-Orientierung sind eine ganze Reihe sehr komplexer Fragen verbunden.

- Konsequenterweise startet dann auch der Einstieg in das Software Defined Data Center nicht mit der Technik, sondern mit den organisatorischen Zielsetzungen: Wie stellt man sich das Rechenzentrum in fünf Jahren vor?

Dr. Jürgen Suppan gilt als einer der führenden Berater für Kommunikationstechnik und verteilte Architekturen. Unter seiner Leitung wurden in den letzten 25 Jahren diverse Projekte aller Größenordnungen erfolgreich umgesetzt. Sein Arbeitsschwerpunkt ist die Analyse neuer Technologien und deren Nutzen für Unternehmen. Er leitet das internationale Labor von ComConsult Research Ltd. in Christchurch, das die Technologieentwicklung in Asien, Australien, den USA und Europa analysiert und für Kunden bewertet. Gleichzeitig ist er Inhaber der ComConsult Akademie, der ComConsult Research GmbH und der ComConsult Technology Information Ltd.

(ID:42367468)

:quality(80)/p7i.vogel.de/wcms/50/dd/50dd3b34f7b0225abc3ee94da6c93031/0129530493v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/1a/ba/1aba22332932c34e5a76094302dfaf82/0129450920v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8c/21/8c21b1401a42efba38ae38b98090007f/0129402963v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/e0/14/e01406fc4ba33f77268d7ca4559b7b21/0129483449v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9c/06/9c065daca35fc3dfc693bfd86a8a5821/0129585612v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8e/c7/8ec7d9771f19ddca4b88d789a5fdc919/0129532677v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/2f/10/2f10d51f9c45ef0ec6e3aec543ba42a8/0129386438v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/f8/02/f8029807b2ea78bfaea71d045dc0282d/0129631770v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/0c/ff/0cff7b9801dfe3fc6ec50eef8983a685/0129411263v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4e/1e/4e1e0e248385be4fff4c3fd47a4d547e/0129381901v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/b0/12/b012932ba5620e0474b49487335dc84d/0129309312v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ff/3e/ff3e593fc00cc07dabb6cb0e9fe0a4a8/0129416033v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/be/ae/beaefe01a87a8cefddaa3de66838f68b/0129578464v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/f8/2f/f82f4f38e4c5dc9e6fff85e539341ff1/0129455026v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/c5/79c5cb8545ed8769f643490ecee932a1/0129176937v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/67/3d/673df458f785f25b05d17f06a62651d1/0129501448v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/f2/14/f214043747c0e09946ba7628365f3c69/0129468201v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/4f/f3/4ff3f0f86eb10677bbdc6b5b7949f217/0129421148v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/3f/dd/3fddccbdfc496ebd8e99ae0733c12b0e/0129301724v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/bb/c3/bbc39c16eb8a1435fa7a974dbea2c2a0/0129384459v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/6d/70/6d70da34e3cfbb2e34505cbd2a492e3d/0129051553v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/5c/11/5c11f1045ad338000113a97d33f44a03/0129446649v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/5e/3a/5e3aa97948121116a29abb56ba42a2d7/0129406763v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/da/ee/daeee14a1cdb5c1372c446d20f8a7f25/0129370055v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/29/03/29030dfb8779101003bec1d1113a64ed/0129159658v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/70/c2/70c210d78553c097f88a093fcdbc0b52/0129096430v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d0/20/d020cef4484c0e7e3bedae1947b4d051/0129616320v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/3c/80/3c805cb11b5b663da65518a0ada9835b/0129594643v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/bc/77/bc77907d41991622264d7d305e939d40/0129539352v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/06/1d/061df04d53accd51897e7b43fba6433e/0129527524v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f3/da/f3dacd38e5834ae3f3c9d0a4bc9664d3/0113348475.jpeg)

:quality(80)/p7i.vogel.de/wcms/90/f5/90f56ec6cb3ddbdabca2162fd5477836/0113078524.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/09/0f097990002b7600075e43c92af4a3fd/0110524571.jpeg)

:quality(80)/p7i.vogel.de/wcms/66/ae/66ae9e32738784b57e2ad8c1a4b0986f/0109756744.jpeg)

:quality(80)/p7i.vogel.de/wcms/ee/3f/ee3f063b82737f0369c09ba7854587b5/0127234708v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f1/f0/f1f007a4518fa65d3cb0ea5ca465142a/0121300054v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/a8/28/a828f76369267628d833a12c26dd6579/0121131534v3.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/8a/c28a3e2b1e5a668e85a60ab1513f0505/0114961639.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/66/c3/66c33d1f71ef2/daxten-logo-600-x-600.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/60/2a/602a8645d40e9/200226---derz-logo.jpg)

:fill(fff,0)/p7i.vogel.de/companies/68/df/68dfe5154f605/consystech-logo-dci.jpeg)

:quality(80)/p7i.vogel.de/wcms/ae/5c/ae5c7e447b9708bcb47cf29d16806a0b/0127929798v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e2/53/e2536d39fc30f50eac25d4bdec1f6c52/0126736347v1.jpeg)